Joseph D’Aleo, CCM, AMS Fellow

Höhepunkte der Temperaturmessung im Zeitstrahl

Praktisch jeden Monat und jedes Jahr lesen wir in den ehemals zuverlässigen Medien und von ehemals unparteiischen Datenzentren Berichte, in denen der wärmste Zeitraum in der gesamten Aufzeichnung bis 1895 oder noch weiter zurück verkündet wird. Die folgenden Ausführungen legen nahe, dass der größte Teil dieses Zeitraums auf modellbasierten Vermutungen beruht.

Anfang der 1970er Jahre – als ich in den 1970er Jahren als Produzent für Wettersendungen tätig war und dann an der Universität Wetter und Klima unterrichtete und später in den 1980er Jahren Mitbegründer des Kabelfernseh-Wetterkanals war, griffen wir auf lokale Klimadaten zurück und nutzten sie, um aktuelle oder vorhergesagte Bedingungen und Extreme ins rechte Licht zu rücken. Wir bezogen uns auf Studien und Berichte in Zeitschriften wie Monthly Weather Review und monatlichen Wettermagazinen wie Weatherwise, die das monatliche und saisonale Wetter und Stürme (Temperatur- und Niederschlagsanomalien in den USA, Hurrikane, Tornados, Dürren, Überschwemmungen und Schneefälle) sowie Temperaturextreme (Minusgrade im Winter und dreistellige Temperaturen im Sommer) zum Thema hatten.

Es wurde nicht versucht, eine offizielle nationale oder globale Routineanalyse durchzuführen und nach Trends zu suchen. Die Idee, dies mit einer gewissen Präzision zu tun, wurde als entmutigend angesehen, wie Sie anhand dieser Zeitleiste sehen werden.

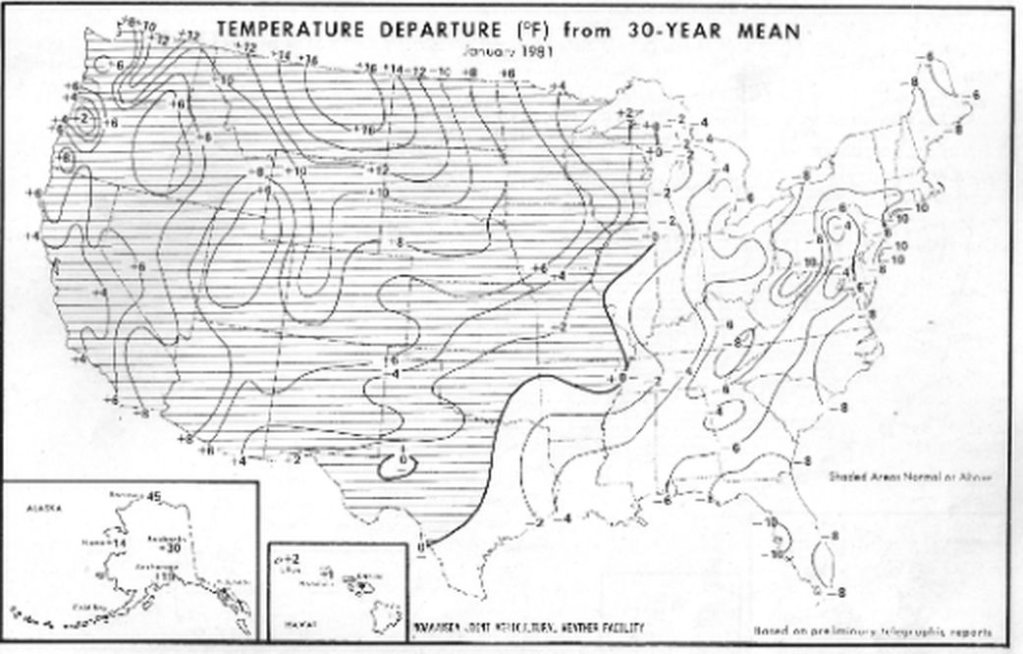

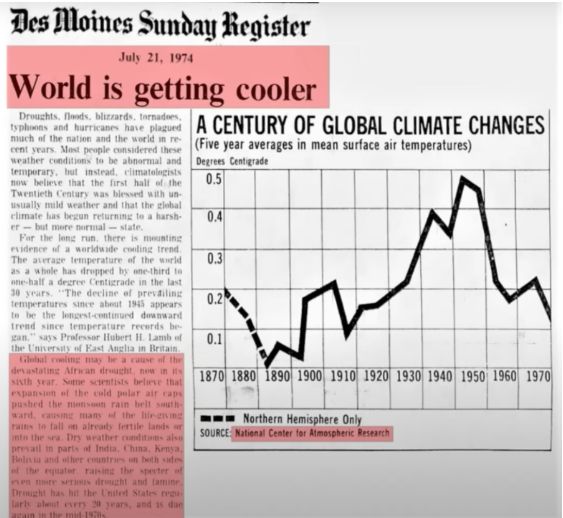

1974: Das National Center Atmospheric Research veröffentlichte eine einmalige Schätzung des Temperaturtrends, die sich auf die Landgebiete der nördlichen Hemisphäre beschränkte (zuverlässige Daten in größerem Maßstab und über den Ozean waren nicht ohne weiteres verfügbar oder vertrauenswürdig). Die Schätzung, über die im Des Moines Register berichtet wurde, zeigte eine dramatische Erwärmung von den 1800er Jahren bis etwa 1940, dann eine Umkehrung, die in einer entsprechenden Abkühlung in den späten 1970er Jahren endete, als sogar die CIA schrieb, dass die Wissenschaftler glaubten, wir könnten auf eine gefährliche neue Eiszeit zusteuern. Die Abkühlung setzte sich bis Ende der 1970er Jahre fort und machte die fast 60 Jahre andauernde Erwärmung nahezu zunichte. Dann folgte wieder eine Erwärmung.

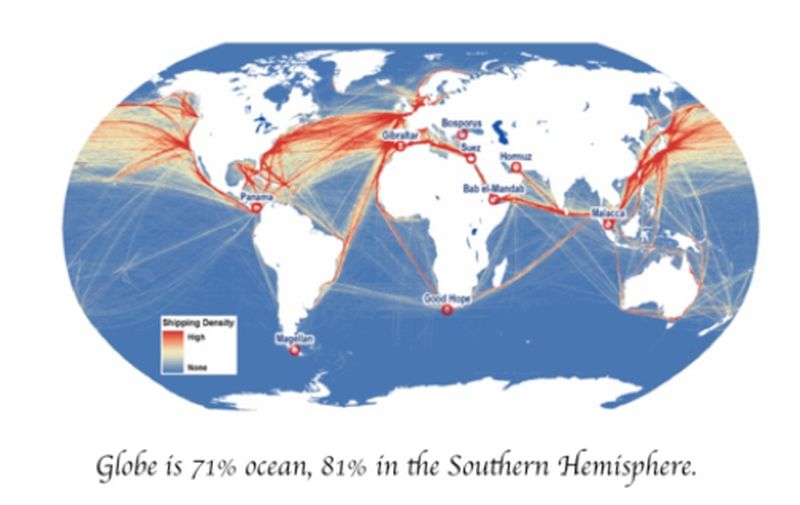

1978: Die New York Times berichtet, dass es zu wenig Temperaturdaten von der südlichen Hemisphäre gibt, um zuverlässige Schlussfolgerungen zu ziehen. Der Bericht, auf den sie sich bezog, wurde von deutschen, japanischen und amerikanischen Fachleuten erstellt und erschien in der Ausgabe vom 15. Dezember der britischen Zeitschrift Nature. Darin heißt es: „Die Daten aus der südlichen Hemisphäre, insbesondere südlich des 30. südlichen Breitengrades, sind so spärlich, dass zuverlässige Schlussfolgerungen nicht möglich sind“, heißt es in dem Bericht. „Die Schiffe fahren auf fest etablierten Routen, so dass weite Teile des Ozeans von Schiffen einfach gar nicht überquert werden, und selbst die Schiffe, die dies tun, liefern möglicherweise keine Wetterdaten von der Route.“

1979: Beginn der globalen satellitengestützten Temperaturmessung der Atmosphäre durch UAH und RSS

1981: James Hansen und andere von der NASA berichten, dass „die Probleme bei der Erstellung einer globalen Temperaturgeschichte auf die ungleichmäßige Verteilung der Stationen zurückzuführen sind, wobei die südliche Hemisphäre und die Ozeangebiete schlecht vertreten sind“ – (Science, 28. August 1981, Band 213, Nummer 4511)

1989: Als Reaktion auf die Notwendigkeit einer genauen, unverfälschten, modernen historischen Klimaaufzeichnung für die Vereinigten Staaten definierten Mitarbeiter des Global Change Research Program des US-Energieministeriums und des NCEI ein Netzwerk von 1219 Stationen in den zusammenhängenden Vereinigten Staaten, deren Beobachtungen einen wichtigen Basisdatensatz für die Überwachung des US-Klimas bilden sollten. Seitdem wurde der USHCN-Datensatz mehrmals überarbeitet (z. B. Karl et al., 1990; Easterling et al., 1996; Menne et al. 2009). Die drei in Quinlan et al. 1987, Karl et al., 1990 und Easterling et al., 1996 beschriebenen Datensätze werden nun als USHCN-Version-1-Datensätze bezeichnet.

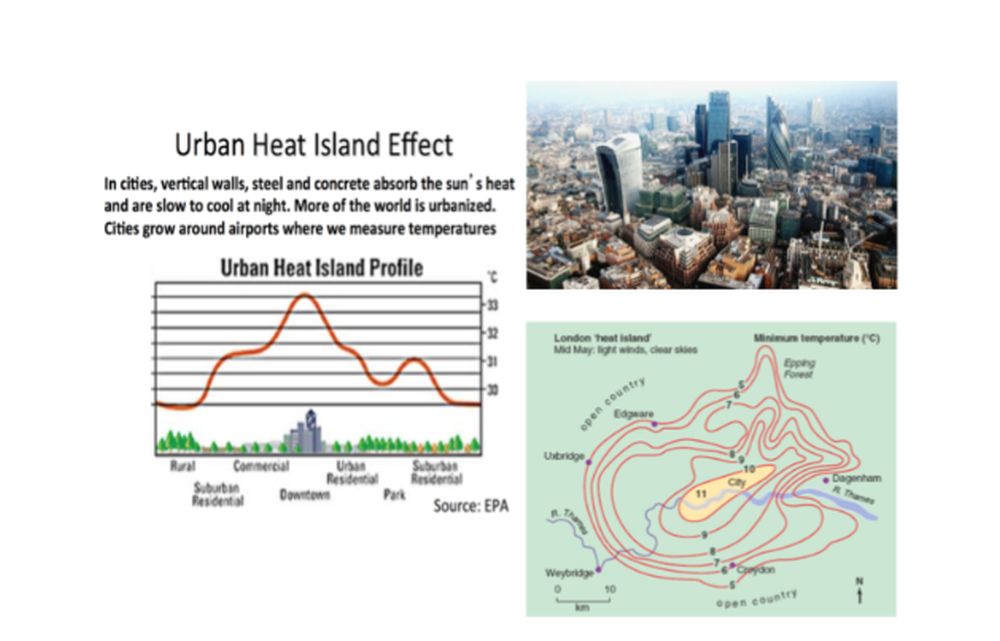

Zu den berücksichtigten dokumentierten Änderungen gehören Änderungen des Beobachtungszeitpunkts (Karl et al. 1986), Stationsverlegungen und Instrumentenwechsel (Karl und Williams, 1987; Quayle et al., 1991). Offensichtliche Verstädterungseffekte wurden in Version 1 ebenfalls mit einer speziellen Korrektur des urbanen Bias berücksichtigt (Karl et al. 1988).

Der erste Klimachef der NOAA, Tom Karl, schrieb 1986 zusammen mit Kukla und Gavin in einer Studie über die Erwärmung in Städten: „Meteosäkulare Trends der Lufttemperatur, die überwiegend aus [städtischen] Stationsdaten berechnet wurden, weisen wahrscheinlich eine ernsthafte Erwärmungsverzerrung auf… Der durchschnittliche Unterschied zwischen den Trends [städtische vs. ländliche Standorte] beläuft sich auf eine jährliche Erwärmungsrate von 0,34°C/Dekade (3,4°C/Jahrhundert)… Der Grund, warum die Erwärmungsrate beträchtlich höher ist, könnte sein, dass die Rate nach den 1950er Jahren zugenommen hat, entsprechend dem starken Wachstum in und um Flughäfen. Unsere und andere Ergebnisse zeigen, dass die Inhomogenität des städtischen Wachstums schwerwiegend ist und bei der Bewertung der Zuverlässigkeit von Temperaturaufzeichnungen berücksichtigt werden muss.“

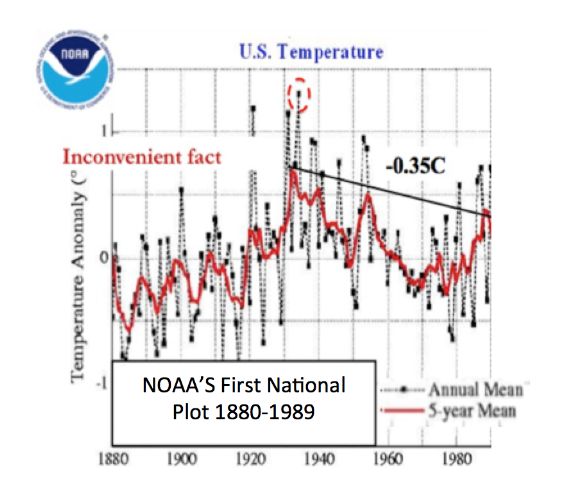

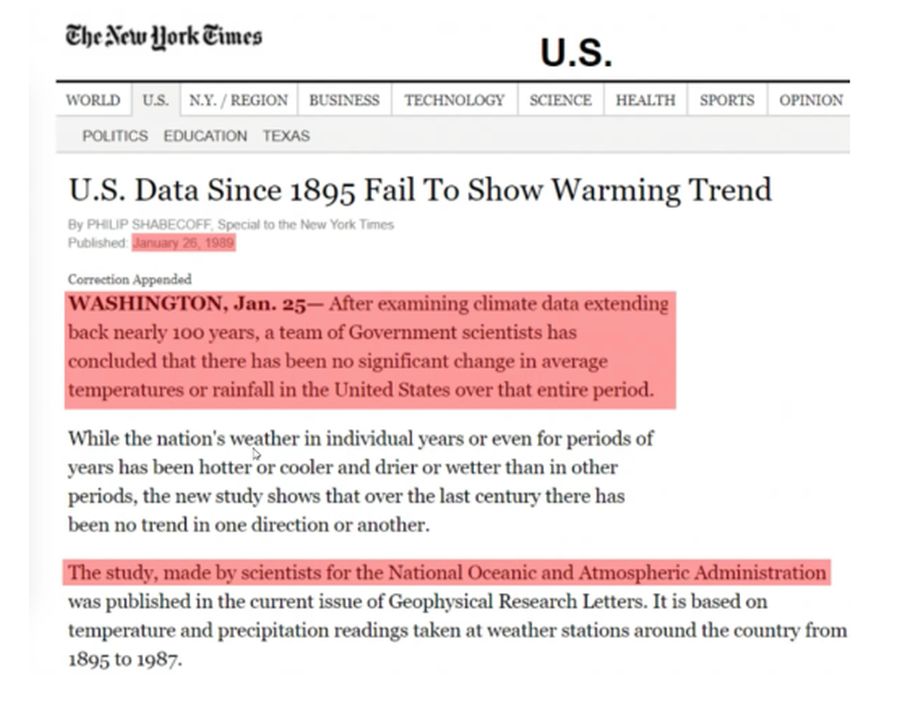

1989: Die NY Times berichtet, dass die US-Daten den von Hansen 1980 vorhergesagten Erwärmungstrend nicht zeigen.

1992: Die erste globale monatliche Bewertung der NOAA begann (GHCNm – Vose). Zu den nachfolgenden Veröffentlichungen gehören Version 2 im Jahr 1997 (Peterson und Vose, 1997), Version 3 im Jahr 2011 (Lawrimore et al. 2011) und zuletzt Version 4 (Menne et al. 2018). GHCNm v4 bestand nur aus mittleren monatlichen Temperaturdaten.

1992: Das Automated Surface Observing System (ASOS) des National Weather Service (NWS), das als primäre Datenquelle für mehr als 900 Flughäfen im ganzen Land dient und für die Archivierung von Klimadaten verwendet wird, wurde in den frühen 1990er Jahren eingeführt. Beachten Sie, dass die Kriterien einen RMSE von 0,4°C und einen maximalen Fehler von 1,1°C vorgaben. ASOS wurde entwickelt, um wichtige Informationen für die Luftfahrt zu liefern, wie z. B. Sichtbarkeit der Obergrenze, Wind, Hinweise auf Gewitter und Vereisung. Es wurde nicht für die Bewertung des Klimas entwickelt.

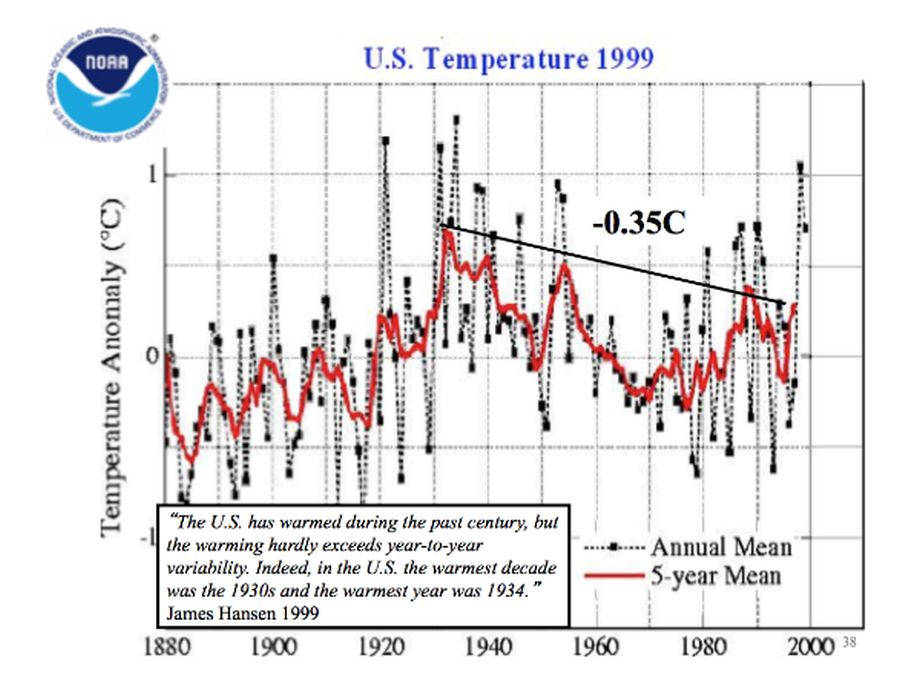

1999: Die USHCN-Temperatur blieb 1934 wie schon ein Jahrzehnt zuvor zurück – James Hansen stellte fest: „Die USA haben sich im vergangenen Jahrhundert erwärmt, aber die Erwärmung übersteigt kaum die Schwankungen von Jahr zu Jahr. In der Tat war das wärmste Jahrzehnt in den USA die 1930er Jahre und das wärmste Jahr 1934.“ Auf die Frage nach dem Grund für diese Diskrepanz sagte Hansen, dass die USA weniger als 2 % der Welt ausmachten und beide Werte richtig sein könnten.

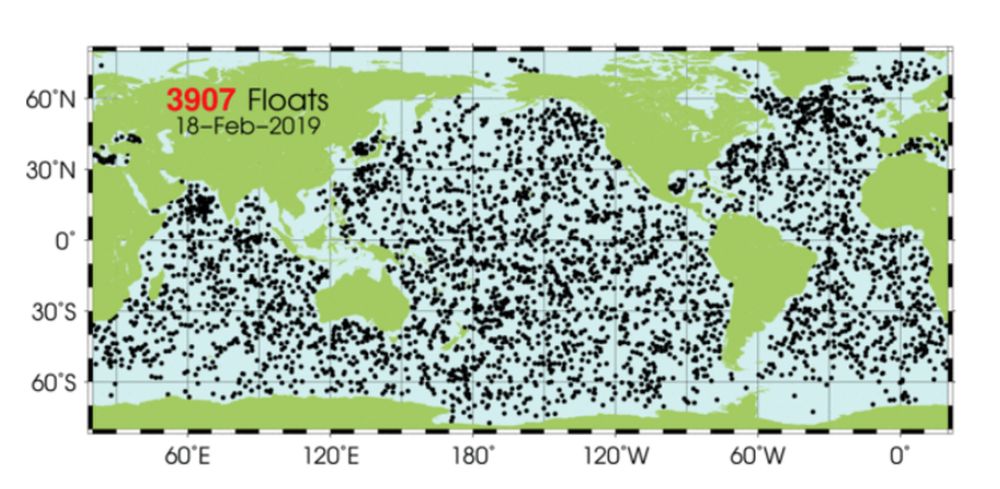

2000: Ein Netz von fast 4000 Tauchbojen (ARGO) wurde weltweit eingesetzt, um die erste Echtzeitüberwachung der Meerestemperaturen und des Wärmeinhalts der Ozeane zu ermöglichen.

2001: Der IPCC räumte in seinem dritten Bericht (2001) ein: „In der Klimaforschung und -modellierung sollten wir anerkennen, dass wir es mit einem gekoppelten nichtlinearen chaotischen System zu tun haben und dass daher eine langfristige Vorhersage künftiger Klimazustände nicht möglich ist.“ (Kapitel 14, Abschnitt 14.2.2.2. )

2004: Das nationale Klimareferenznetz wurde mit Hilfe von John Christy von der UAH eingerichtet, um unverfälschte Temperaturen in den 48 Staaten zu liefern. Die 114 Stationen erfüllten die Spezifikationen, die sie von lokalen Wärmequellen fernhielten.

2005: Pielke und Davey (2005) stellten fest, dass die Mehrheit der Stationen, einschließlich der Klimastationen im östlichen Colorado, nicht den Anforderungen an eine ordnungsgemäße Standortwahl entsprachen. In zahlreichen von Fachleuten begutachteten Veröffentlichungen dokumentierten sie ausführlich die Probleme der mangelhaften Standortwahl und Landnutzungsänderungen, darunter „Unresolved issues with the assessment of multi–decadal global land surface temperature trends“ (2007)

2007: Eine neue Version, USHCNv2, ersetzte die Anpassung für die städtische Erwärmung durch erhebliche andere Anpassungen, einschließlich der Entfernung der Anpassungen für die städtische Erwärmung, die durch „Homogenisierung“ ersetzt wurden. Der Trend kehrte sich um: 1998 ist nun wärmer als 1934 und der mittlere Trend ist höher als in den 1930er Jahren.

David Easterling, Leiter der wissenschaftlichen Abteilung des NOAA-Klimazentrums, äußerte sich in einem Brief an James Hansen von der NASA besorgt: „Ein Wermutstropfen ist ein neues Anpassungsschema für USHCNv2, das einige, wenn nicht sogar alle lokalen Trends, die Landnutzungsänderungen und die Erwärmung in den Städten einschließen, auszugleichen scheint.“ Es reduziert den „lästigen warmen Fleck von 1940“, den die Warmisten minimieren wollten.

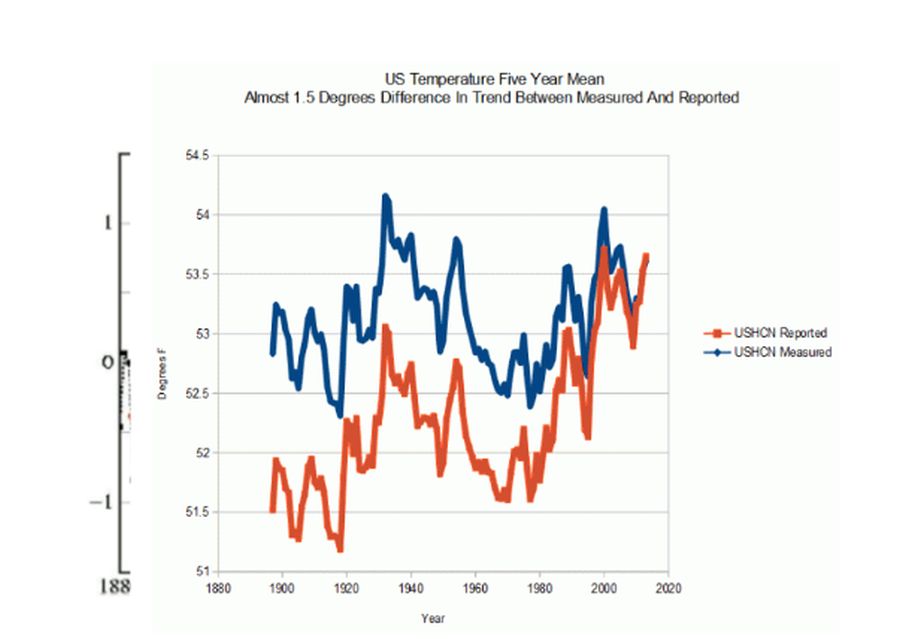

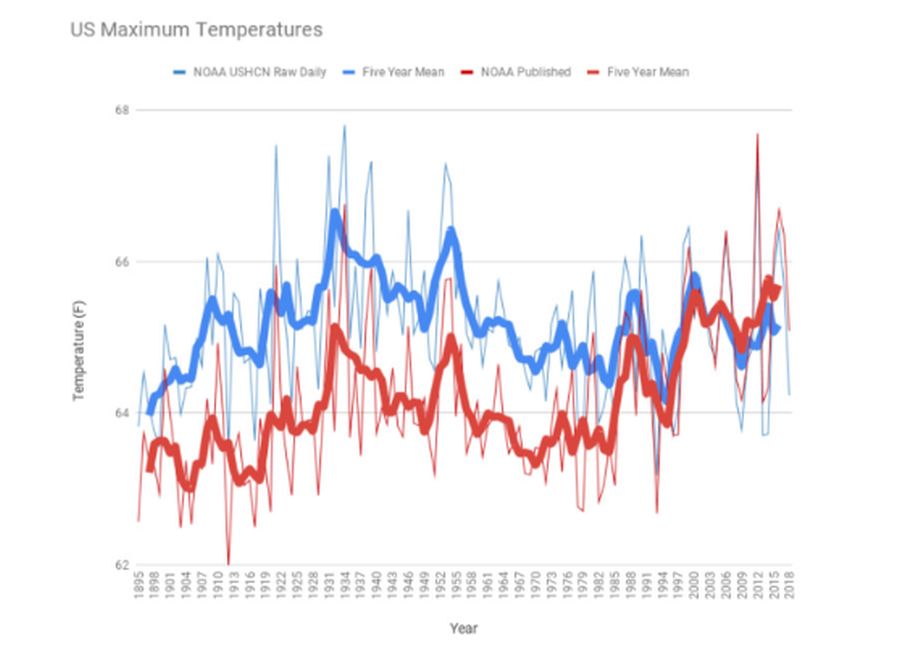

Siehe Tony Hellers Diagramm der NOAA USHCN-Höchsttemperatur (5-Jahres-Mittelwert und jährlich) für die gemessenen Daten (blau) und die „gemeldete“ Temperatur (rot).

Die Höchsttemperatur ist ein besseres Maß für Trends, da sie nicht durch die städtische Wärmeinsel verfälscht wird, die vor allem die Minima erhöht. Die NASA-Daten haben sich im Einklang mit den NOAA-Daten verändert. Zwischen 2008 und 2018 fügte NASA GISS dem Zeitraum von 1910 bis 2000 eine trendverstärkende Erwärmung um 0,24 °C hinzu. Um diese Veränderung zu erreichen, wurden die Temperaturen vor 1950 abgekühlt und die jüngeren Temperaturen erwärmt, um einen lineareren Erwärmungstrend zu erzeugen. Kenneth Richards erklärte in No TricksZone: „Da es beträchtliche Beweise dafür gibt, dass die Integrität der Klimaaufzeichnungen beeinträchtigt wurde, ist es vielleicht an der Zeit zu überdenken, wie die globalen Temperaturtrends aussehen könnten, wenn sie nicht so ‚korrigiert‘ werden, dass sie in die von den Datenüberwachern bevorzugte Darstellung passen.“

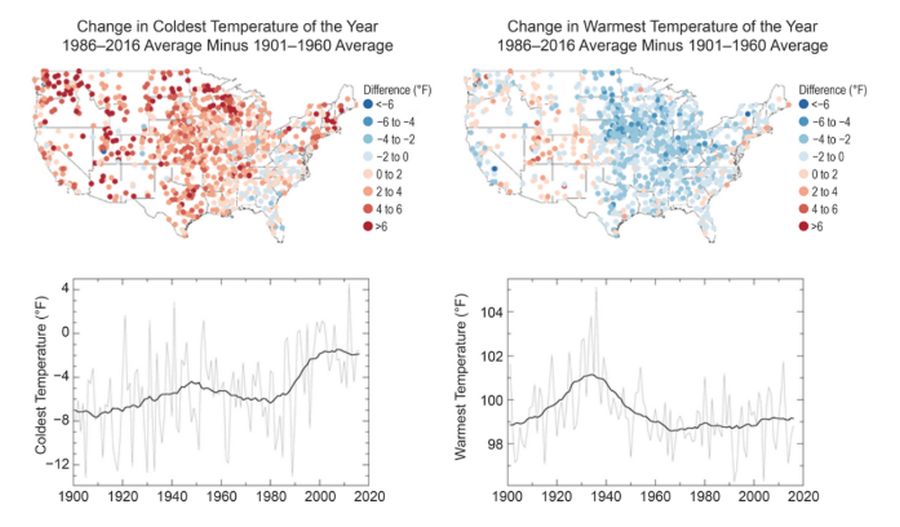

Im vierten nationalen Klimabericht (NCA4) des U.S. Global Change Research Program (USGCRP) wurden die Maximal- und Minimaltemperaturen von 1986 bis 2016 im Langzeitvergleich (1901-1960) verglichen und es zeigte sich, dass die Maximaltemperaturen in den zentralen bis östlichen USA gesunken sind. Die Minima waren vor allem in der Mitte, im Nordwesten und im Nordosten höher.

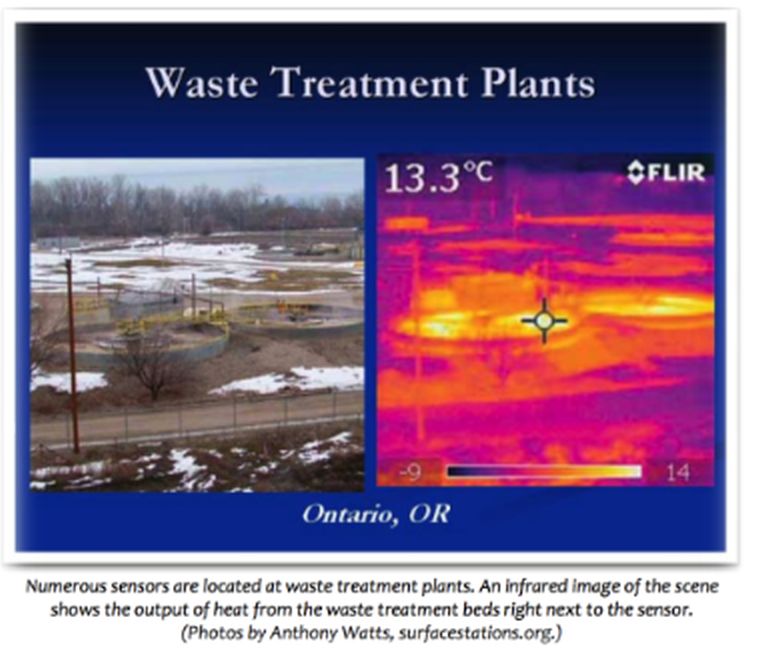

2008: Im Rahmen eines Projekts einer ehrenamtlichen Befragung haben Anthony Watts und seine mehr als 650 Freiwilligen auf www.surfacestations.org festgestellt, dass über 900 der ersten 1 067 Stationen des 1 221 Stationen umfassenden US-Klimanetzes nicht annähernd den Spezifikationen entsprachen, die in den Kriterien des Klimareferenznetzes (CRN) festgelegt sind. Nur etwa 3 % entsprachen der idealen Spezifikation für die Standortwahl. Die Stationen befanden sich neben den Abluftventilatoren von Klimaanlagen, umgeben von asphaltierten Parkplätzen und Straßen, auf glühend heißen Dächern und in der Nähe von Gehwegen und Gebäuden, die Wärme absorbieren und ausstrahlen.

Die Forscher fanden 68 Stationen in Kläranlagen, wo der Prozess der Abfallvergärung zu höheren Temperaturen führt als in den umliegenden Gebieten. Tatsächlich stellten sie fest, dass 90 % der Stationen nicht den eigenen Standortanforderungen des National Weather Service entsprechen, wonach die Stationen mindestens 30 m von einer künstlichen Heiz- oder Reflexionsquelle entfernt sein müssen.

[Anmerkung: Auch beim EIKE sind diese Manipulationen öfter dokumentiert worden – sie gehen alle in die gleiche Richtung. Siehe u. A. hier und hier und hier und hier. A. d. Übers.]

2009: Climategate-E-Mails mit aufschlussreichen Kommentaren über die lästige Wärmeerscheinung von 1940 und Daten, welche die Modelle nicht unterstützen.

Tom Wigley, Datum: Sonntag, 27. September 2009: „Wenn wir also den Ozeanausschlag um, sagen wir, 0,15 Grad Celsius reduzieren könnten, dann wäre das für den globalen Mittelwert signifikant – aber wir müssten immer noch den Landausschlag erklären. Ich habe hier absichtlich 0,15 gewählt. Damit bleibt immer noch ein Ozean-Sprung übrig, und ich denke, man braucht eine Form des Ozean-Sprungs, um den Land-Sprung zu erklären (entweder durch einen gemeinsamen Antrieb oder durch den Ozean, der das Land antreibt, oder umgekehrt, oder durch all diese Faktoren).“

Tom Wigley, Datum: Freitag, 6. November 2009: „Wir müssen wahrscheinlich mehr dazu sagen. Die Erwärmung an Land seit 1980 war doppelt so hoch wie die Erwärmung im Ozean – und Skeptiker könnten behaupten, dass dies beweist, dass die Erwärmung in den Städten real und wichtig ist.“

Kevin Trenberth, Mittwoch, 14. Oktober 2009: „Tatsache ist, dass wir die fehlende Erwärmung im Moment nicht erklären können, und es ist eine Schande, dass wir das nicht können. Die CERES-Daten, die im August in der BAMS 09-Beilage zu 2008 veröffentlicht wurden, zeigen, dass es noch mehr Erwärmung geben sollte: aber die Daten sind sicherlich falsch. Unser Beobachtungssystem ist unzureichend.“

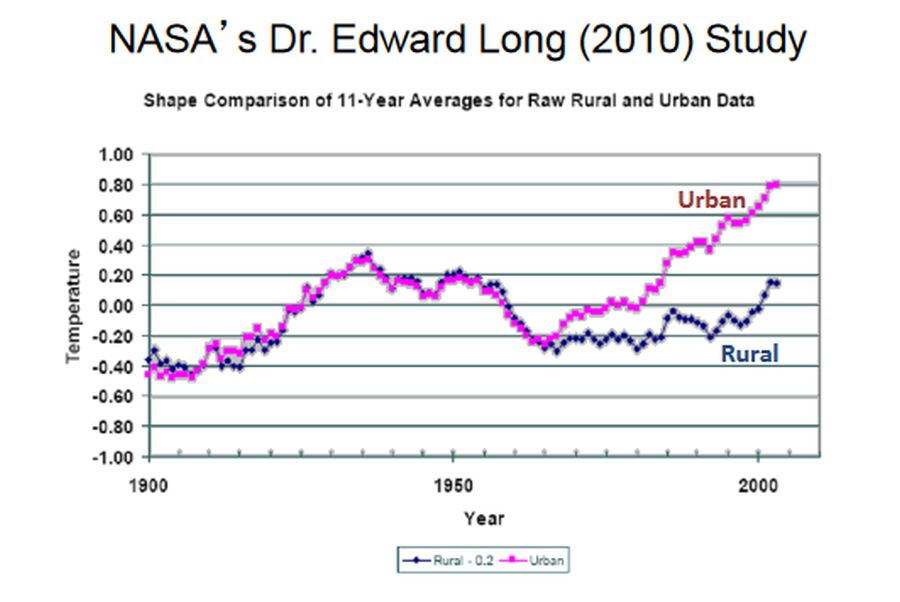

2009: Dr. Edward R. Long von der NASA untersuchte in einer Analyse von 2009 die neue Version der US-Daten. Sowohl die Rohdaten als auch die bereinigten Daten des NCDC (jetzt NCEI) wurden für eine Reihe ausgewählter ländlicher und städtischer Stationen (jeweils 48 oder eine pro Bundesstaat) in den zusammenhängenden USA untersucht. Die Rohdaten ergaben einen Temperaturanstieg von 0,13 und 0,79 °C/Jahrhundert für die ländliche und städtische Umgebung, was mit den städtischen Faktoren übereinstimmt. Die bereinigten Daten ergaben 0,64 bzw. 0,77 Grad Celsius pro Jahrhundert.

Ein Vergleich der bereinigten Daten für den ländlichen Bereich mit den Rohdaten zeigt eine systematische Behandlung, die dazu führt, dass die Temperaturanstiegsrate des korrigierten ländlichen Bereichs um das Fünffache höher ist als die der Rohdaten. Dies deutet darauf hin, dass das NCDC-Protokoll zur Anpassung der Daten dazu führt, dass die historischen Daten die zeitlichen Merkmale der städtischen Daten annehmen. Die Folge ist, ob beabsichtigt oder nicht, die Angabe einer falschen Temperaturanstiegsrate für die zusammenhängenden USA, die mit der Modellierung unter Verwendung der Treibhaustheorie übereinstimmt.

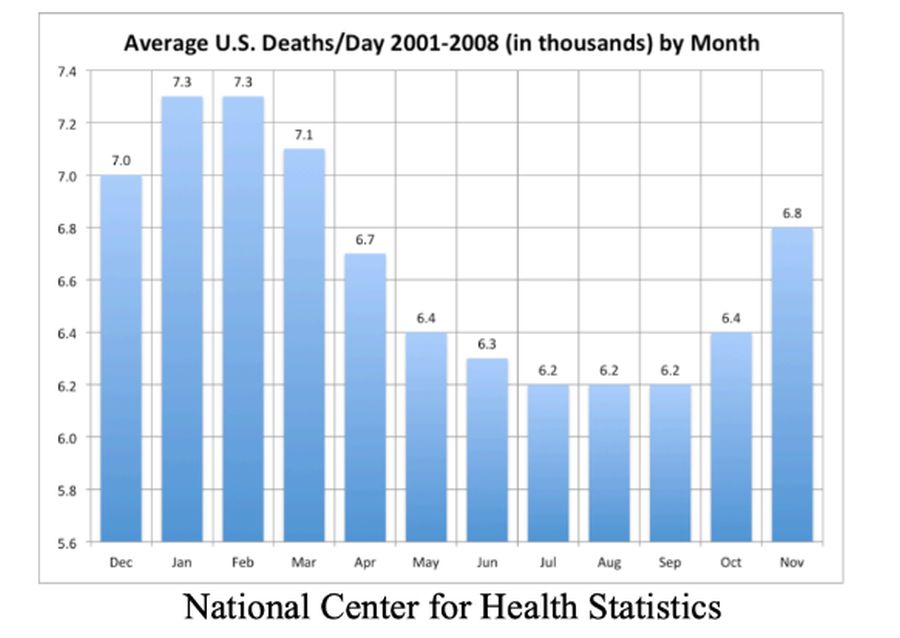

2009: Indur M. Goklany schrieb im Jahre 2009: „Daten des Nationalen Zentrums für Gesundheitsstatistiken der USA für den Zeitraum 2001-2008 zeigen, dass in den Monaten Dezember, Januar, Februar und März durchschnittlich 7.200 Amerikaner pro Tag starben, verglichen mit durchschnittlich 6.400, die während des restlichen Jahres täglich starben. Im Jahr 2008 gab es 108 500 „überzählige“ Todesfälle während der 122 Tage in den kalten Monaten (Dezember bis März).

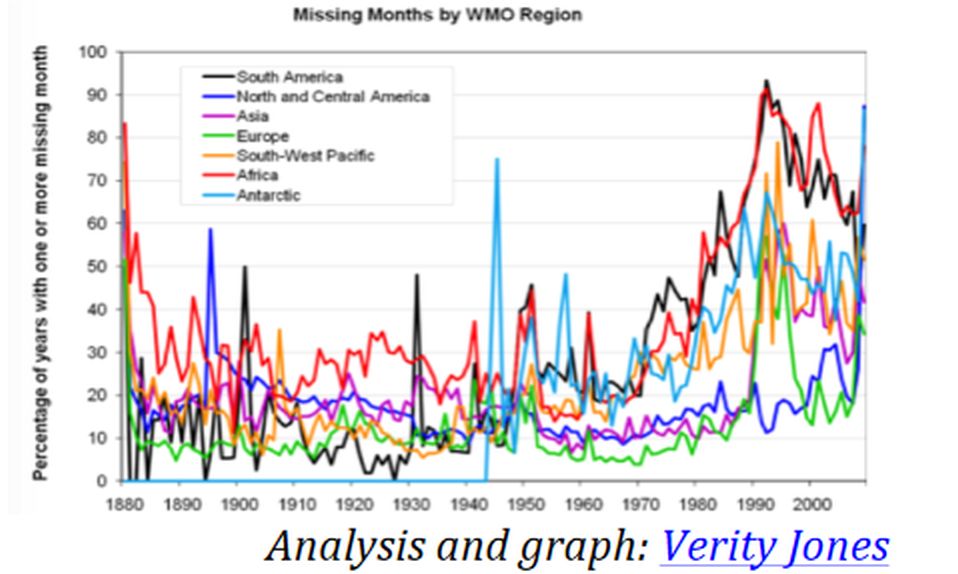

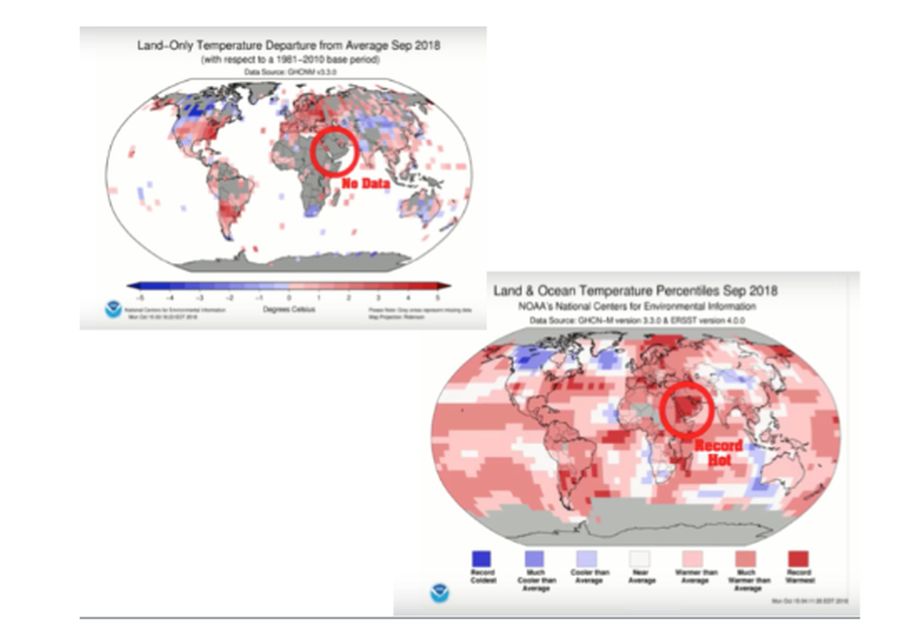

2010: 2009 veröffentlichte eine große Gruppe von Klimawissenschaftlern einen Überblick über die Temperaturproblematik mit dem Titel Surface Temperature Records: Eine politisch motivierte Täuschung. Darin wurden viele Probleme in den USA und weltweit erörtert. Selbst als die Zahl der Stationen in den globalen Datensätzen zunahm, wurde ihre Zuverlässigkeit zu einer Herausforderung, da viele große Kontinente einen hohen Prozentsatz an fehlenden Monaten in den Stationsdaten aufwiesen. Dies erforderte von den Datenzentren, die fehlenden Daten zu schätzen, um einen monatlichen und dann einen jährlichen Durchschnitt zu erhalten.

Viele werden überrascht sein, dass dieses Problem fehlender Daten in der obigen Abbildung auch heute noch besteht. Tatsächlich scheint es noch schlimmer zu sein, wenn fehlende Daten anhand von Daten der nächstgelegenen Stationen geschätzt werden, die manchmal viele hundert Kilometer entfernt sind. Sehen Sie sich die ersten Datenbereiche im September 2018 an, die durch Algorithmen ausgefüllt wurden. Dazu gehört das Ausfüllen eines großen Datenlückenbereichs mit einer Wärmerekordbewertung (Heller 2018).

2010: Eine wegweisende Studie mit dem Titel [übersetzt] „Analyse der Auswirkungen der Stationsexposition auf die Temperaturen und Temperaturtrends des U.S. Historical Climatology Network“, verfasst von Souleymane Fall, Anthony Watts, John Nielsen-Gammon, Evan Jones, Dev Niyogi, John R. Christy, Roger A. Pielke Sr, war das Ergebnis jahrelanger Arbeit zur Untersuchung der Qualität des Temperaturmesssystems der Vereinigten Staaten. Die Studie untersuchte Temperaturunterschiede zwischen verschiedenen Standortqualitätsstufen. Sie fanden heraus, dass Temperatur-Trendschätzungen je nach Standortklassifizierung variieren, wobei eine schlechte Standortwahl zu einer Überschätzung der Tiefsttemperaturtrends führt, was wiederum eine übertriebene Erhöhung der Durchschnittstemperaturen zur Folge hat.

2010: In einer durch diesen Befund ausgelösten Überprüfung stellte das GAO fest: „42 % der aktiven USHCN-Stationen im Jahr 2010 erfüllten eindeutig nicht die Standortstandards der NOAA. Darüber hinaus liegen nur für 24 der 1.218 Stationen (etwa 2 %) vollständige Daten aus der Zeit ihrer Errichtung vor.“

2010: Der im Zentrum des Climategate-Skandals stehende CRU-Wissenschaftler an der East Anglia University, Phil Jones, gab 2010 bei der BBC freimütig zu, dass seine „Temperaturdaten in einem derartigen Durcheinander sind, dass sie vermutlich weder verifiziert noch reproduziert werden können, dass es in den letzten 15 Jahren keine statistisch signifikante globale Erwärmung gegeben hat und dass die Tendenz zwischen 2002 und 2009 bei 0,12°C pro Jahrzehnt lag.“

2013: Die NOAA reagierte auf die Studien zur Standortwahl und die Ermahnung des GAO, indem sie die schlechtesten Stationen entfernte und/oder ersetzte. Außerdem werden in den monatlichen Pressemitteilungen niemals Satellitenmessungen erwähnt, obwohl die NOAA Karl gesagt hatte, dass dies die Zukunft der Beobachtungen sei.

2015: Eine Pause in der Erwärmung, die um 1997 begann, wurde schließlich in der Zeitschrift Nature von Kevin Trenberth, dem Hauptautor des IPCC, anerkannt und auf zyklische Einflüsse natürlicher Faktoren wie El Nino und Ozeanzyklen auf das globale Klima zurückgeführt. Auf der AMS-Jahrestagung 2015 gab es 3 Foren, die sich mit der „Pause“ befassten.

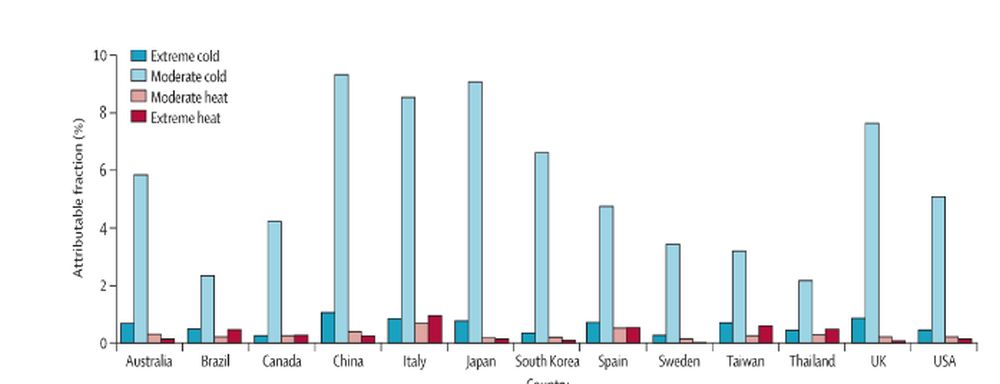

2015: Regierungsbehörden und Medienberichterstatter betonen weiterhin die Gefahr von Hitze und ignorieren Kälte in ihren Studien und Berichten. Die mit dieser Irreführung verbundene Gefahr besteht darin, dass kaltes Wetter 20 Mal so viele Menschen tötet wie warmes Wetter. Dies geht aus einer internationalen Studie hervor, in der über 74 Millionen Todesfälle an 384 Orten in 13 Ländern untersucht wurden. Die Ergebnisse wurden in The Lancet veröffentlicht.

„Man geht oft davon aus, dass extremes Wetter die meisten Todesfälle verursacht, wobei sich die meisten bisherigen Untersuchungen auf die Auswirkungen extremer Hitzewellen konzentrieren“, sagt der Hauptautor Dr. Antonio Gasparrini von der London School of Hygiene & Tropical Medicine in UK.

In der Studie wurden über 74 Millionen (74.225.200) Todesfälle zwischen 1985 und 2012 in 13 Ländern mit einem breiten Spektrum an Klimazonen untersucht – von kalt bis subtropisch. Anhand von Daten über die tägliche Durchschnittstemperatur, die Sterberaten und Störvariablen (z. B. Luftfeuchtigkeit und Luftverschmutzung) wurde die Temperatur mit der geringsten Sterblichkeit (die optimale Temperatur) berechnet und die Gesamtzahl der Todesfälle aufgrund nicht optimaler Umgebungstemperaturen an den einzelnen Standorten ermittelt. Etwa 7,71 % aller Todesfälle wurden durch nicht optimale Temperaturen verursacht, wobei es erhebliche Unterschiede zwischen den Ländern gab, die von etwa 3 % in Thailand, Brasilien und Schweden bis zu etwa 11 % in China, Italien und Japan reichten. Kälte war für die meisten dieser Todesfälle verantwortlich (7,29 % aller Todesfälle), während nur 0,42 % aller Todesfälle auf Hitze zurückzuführen waren.

Dr. Gasparrini: „Die derzeitigen Maßnahmen im Bereich der öffentlichen Gesundheit konzentrieren sich fast ausschließlich auf die Minimierung der gesundheitlichen Folgen von Hitzewellen. Unsere Ergebnisse deuten darauf hin, dass diese Maßnahmen neu ausgerichtet und erweitert werden müssen, um eine ganze Reihe von mit der Temperatur verbundenen Auswirkungen zu berücksichtigen.“

2015: Unter Druck beendete die NOAA die Pause, indem sie die von den Argo-Bojen gemessenen Ozeantemperaturen änderte, um sie besser an die von den Schiffen in angesaugtem Wasser gemessenen Temperaturen anzupassen, die in den vergangenen Jahrzehnten trotz der Bedenken wegen der von den Schiffsmotoren ausgehenden Wärmeverschmutzung zur vorherrschenden Methode geworden waren. Dies führte dazu, dass die globalen Oberflächendaten besser zur Theorie der Erwärmung des Treibhauses passten. John Bates, Datenqualitätsbeauftragter bei der NOAA, beschrieb in einer Studie in Science im Juni 2015, nur wenige Monate bevor sich die Staats- und Regierungschefs in Paris auf ein kostspieliges Pariser Klimaabkommen einigen sollten, wie Tom Karl die unbequeme Pause durch die Veränderung der Meerestemperaturen beseitigte. Da die Ozeane 71 % des Erdballs bedecken, haben selbst kleine Änderungen große Auswirkungen.

2017: Ein neuer US-Klimadatensatz nClimDiv mit Modellrekonstruktionen der Klimaabteilung und landesweiten Durchschnittswerten wurde schrittweise eingeführt und ersetzte USHCNv2. Das Ergebnis war, dass die NOAA für 40 der 48 US-Bundesstaaten eine „neue“ Erwärmung angab. Die dekadische CONUS-Erwärmungsrate Drd964x von 1895 bis 2012 betrug 0,05°C/Dekade. Die neue nClimDiv-Rate von 1895 bis 2014 beträgt nun plötzlich 0,08°C/Dekade.

2017: In dem Forschungsbericht mit dem Titel On the Validity of NOAA, NASA and Hadley CRU Global Average Surface Temperature Data & The Validity of EPA’s CO2 Endangerment Finding, Abridged Research Report haben Dr. James P. Wallace III, Joseph S. D’Aleo, Dr. Craig D. Idso im Juni 2017 hinreichende Beweise dafür vorgelegt, dass die Daten der Global Average Surface Temperature (GAST) für die Verwendung in der Klimamodellierung und für jeden anderen Zweck der Analyse der Klimawandelpolitik ungültig sind.

„Die schlüssigen Ergebnisse dieser Forschung sind, dass die drei GAST-Datensätze keine gültige Darstellung der Realität sind. Das Ausmaß ihrer historischen Datenanpassungen, durch die ihre zyklischen Temperaturmuster entfernt wurden, steht in völligem Widerspruch zu veröffentlichten und glaubwürdigen Temperaturdaten aus den USA und anderen Ländern. Daher ist es unmöglich, aus den drei veröffentlichten GAST-Datensätzen zu schließen, dass die letzten Jahre die wärmsten aller Zeiten waren – trotz der aktuellen Behauptungen einer rekordverdächtigen Erwärmung.“

2018: In diesem Folgebericht wird argumentiert, dass die Frage der statistischen Signifikanz der Auswirkungen von Treibhausgasen mit geeigneten mathematischen Methoden angegangen werden muss. Solche Methoden werden auch in diesem neuen Forschungsbericht verwendet und beweisen, dass steigende atmosphärische CO₂-Konzentrationen keinen statistisch signifikanten Einfluss auf den UAH TLT 6.0 Temperaturdatensatz im Zeitraum 1979 bis 2016 hatten. Der Forschungsbericht zeigt, dass es eine „Pause“ im UAH TLT-Temperaturtrendanstieg im Zeitraum 1995 bis 2016 gab. Dies ist ein Zeitraum, in dem die atmosphärische CO₂-Konzentration um über 12,0 % gestiegen ist.“

2019: Tony Thomas in Quadrant Online über Dr. Mototaka Nakamura, der in einem Buch über „den traurigen Zustand der Klimawissenschaft“ mit dem Titel „Bekenntnisse eines Klimawissenschaftlers: Die Hypothese der globalen Erwärmung ist eine unbewiesene Hypothese“ schrieb: „Die angebliche Messung der globalen Durchschnittstemperaturen seit 1890 basiert auf Thermometerablesungen, die kaum 5 Prozent des Globus‘ abdecken, bis die Satellitenära vor 40-50 Jahren begann.“ Außerdem verachtete er die Behauptungen über die „Validierung“ von Modellen und sagte, dass die Modellierer lediglich „versuchen, Erzählungen zu konstruieren, die die Verwendung dieser Modelle für Klimavorhersagen rechtfertigen.“ Und er schloss: „Da die Werte der Parameter, die viele komplexe Prozesse darstellen sollen, konstant gehalten werden, sind viele nichtlineare Prozesse im realen Klimasystem in den Modellen nicht vorhanden oder stark verzerrt. Es ist eine Illusion zu glauben, dass Simulationsmodelle, in denen wichtige nichtlineare Prozesse im realen Klimasystem fehlen, (auch) den Sinn oder die Richtung des Klimawandels korrekt vorhersagen können“.

2019: Der oben zitierte Forschungsbericht von Wallace et al. vom Juni 2017 und die Studie von Christy et al. (2018) vom Mai 2018 über die „Untersuchung der in der Klimaforschung verwendeten weltraumgestützten atmosphärischen Großraumtemperaturen“ lieferten hinreichende Beweise dafür, dass die Daten der globalen durchschnittlichen Temperatur (GAST) für die Verwendung in Klimamodellen und für alle anderen Zwecke der Analyse der Klimawandelpolitik ungültig sind. Darüber hinaus lieferten diese Berichte reichlich Beweise dafür, dass die aktuellen, offiziell gemeldeten GAST-Daten einfach nicht glaubwürdig sind und somit die Gefährdungsermittlung von 2009 ungültig machen. Es gab jedoch ein sehr kritisches wissenschaftliches Argument, das in keinem der beiden Berichte angeführt wurde, das aber im Addendum zum Forschungsbericht vom Juni 2017 enthalten ist.

Der Nachtrag macht deutlich, dass es einen völlig unabhängigen Beweis gibt, der viel leichter zu verstehen ist. Für den Zeitraum von 1900 bis 2000 gibt es für mindestens 40 % der Erdoberfläche praktisch keine glaubwürdigen Temperaturdaten. Dies ergibt sich aus der Tatsache, dass die Oberfläche der südlichen Hemisphäre zu über 80 % aus Ozeanen besteht (.50*.80=40), und dass für diese riesigen Ozeane in diesem Zeitraum praktisch keine glaubwürdigen Temperaturdaten erfasst wurden.

Daher war es nie sinnvoll, auch nur den Versuch zu unternehmen, einen GAST-Datensatz über diesen Zeitraum zu berechnen, es sei denn, man wollte einen Temperaturdatensatz erstellen, der über diesen Zeitraum praktisch jedes beliebige Muster aufweisen könnte, das die beteiligten Institutionen als Realität darstellen wollten. Da für weit über 40 % der Erdoberfläche buchstäblich keine glaubwürdigen Temperaturdaten zur Verfügung standen, waren diese Institutionen in Wahrheit nur durch das begrenzt, was für die Außenwelt glaubwürdig war.

In Unkenntnis dieser Fakten haben alle relevanten Parteien, z. B. Regulierungsbehörden, Umweltschützer und Regierungsbeamte, die GAST-Aufzeichnungen bisher viel zu sehr als gültige globale Temperaturdatenbank akzeptiert. Da nun separat nachgewiesen wurde, dass die GAST-Daten kein gültiges Abbild der Realität sind, bedeutet dies auch, dass die CO₂-Bedrohungsfeststellung von 2009 erneut für ungültig erklärt wurde – was bedeutet, dass die anderen drei ebenfalls ungültig sind.

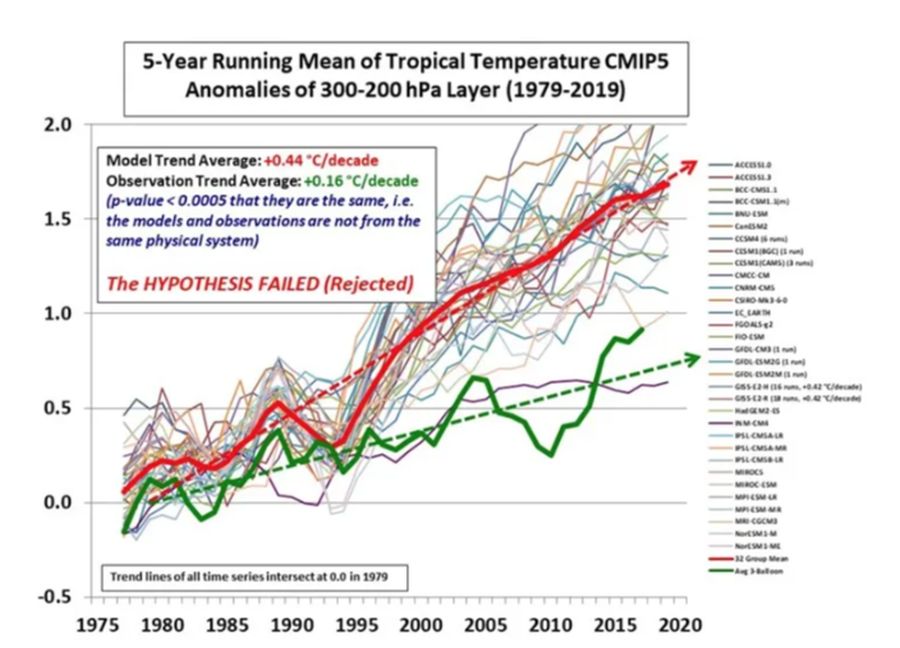

2019: Als letzter Nagel im Sarg gehen alle Treibhausmodelle von einem so genannten tropischen Hot Spot aus, d. h. die Erwärmung in der höheren tropischen Atmosphäre wäre größer als die Oberflächenerwärmung, was zu einer Erwärmung von oben nach unten führen würde. In Übereinstimmung mit der Abbildung unten zeigen jedoch sowohl die UAH- und RSS-Satellitendaten als auch die Wetterballondaten, dass die Erwärmung in der hohen Atmosphäre weniger als die Hälfte der Erwärmung an der Oberfläche beträgt.

Die Klimamodelle sind also aus mindestens zwei Gründen ungültig: Erstens gehen sie alle von der Existenz eines nicht existierenden tropischen Hotspots aus, und zweitens sind sie alle so abgestimmt, dass sie die inzwischen erwiesenermaßen völlig gefälschten Daten zur globalen durchschnittlichen Temperatur am besten erklären.

2022: Im Bericht: „96% der US-Klimadaten sind korrumpiert“ wurde unter der Leitung von Anthony Watts und David Legates eine gründliche Analyse der Stationsstandorte durchgeführt, und man kam zu dem Schluss, dass die Entfernung der am stärksten exponierten Stationen nur an der Oberfläche kratzte und die Mehrheit der Stationen immer noch verzerrt war und die tatsächlichen Trends in den wenigen verbleibenden, korrekt platzierten Stationen durch Homogenisierung (Vermischung) verfälschte.

2024: The Epoch Times berichtet am 9. April 2024 in Hidden Behind Climate Policies, dass Daten von nicht existierenden Temperaturstationen verwendet werden. „Hunderte von ‚Geister‘-Klimastationen sind nicht mehr in Betrieb; stattdessen werden ihnen Temperaturen von umliegenden Stationen zugeordnet.“

Übersetzt von Christian Freuer für das EIKE

Anmerkung: Die Links aus diesem PDF konnten leider nicht hinterlegt werden.

Der Beitrag Die Hypothese der globalen Erwärmung kann aufgrund von Problemen mit Oberflächendaten nicht validiert werden erschien zuerst auf EIKE – Europäisches Institut für Klima & Energie.